Les «Twitter Files» de Musk offrent un aperçu de la tâche brute, compliquée et ingrate de la modération • TechCrunch

Le nouveau propriétaire de Twitter, Elon Musk, fait fébrilement la promotion de son “Fichiers Twitter”: des communications internes sélectionnées de l’entreprise, laborieusement tweetées par des amanuenses sympathiques. Mais la conviction évidente de Musk qu’il a publié un kraken partisan est erronée – loin du complot ou de l’abus systémique, les fichiers sont un aperçu précieux derrière le rideau de modération à grande échelle, faisant allusion aux travaux de Sisyphe entrepris par chaque plate-forme de médias sociaux.

Pendant une décennie, des entreprises comme Twitter, YouTube et Facebook ont exécuté une danse élaborée pour garder les détails de leurs processus de modération également hors de portée des mauvais acteurs, des régulateurs et de la presse.

En révéler trop reviendrait à exposer les processus à des abus de la part des spammeurs et des escrocs (qui profitent en effet de chaque détail divulgué ou publié), tandis que révéler trop peu conduit à des rapports et des rumeurs préjudiciables à mesure qu’ils perdent le contrôle du récit. En attendant, ils doivent être prêts à justifier et à documenter leurs méthodes sous peine de censure et d’amendes de la part des instances gouvernementales.

Le résultat est que même si tout le monde connaît un peu sur la manière exacte dont ces entreprises inspectent, filtrent et organisent le contenu publié sur leurs plateformes, c’est juste assez pour être sûr que ce que nous voyons n’est que la pointe de l’iceberg.

Parfois, il y a des exposés sur les méthodes que nous soupçonnions – des sous-traitants à l’heure cliquant sur des images violentes et sexuelles, une industrie odieuse mais apparemment nécessaire. Parfois, les entreprises exagèrent leurs mains, comme des affirmations répétées sur la façon dont l’IA révolutionne la modération et des rapports ultérieurs selon lesquels les systèmes d’IA à cette fin sont impénétrables et peu fiables.

Ce qui n’arrive presque jamais – généralement les entreprises ne le font pas à moins d’y être forcées – c’est que les outils et processus réels de modération de contenu à grande échelle sont exposés sans filtre. Et c’est ce que Musk a fait, peut-être à ses risques et périls, mais sûrement dans le grand intérêt de tous ceux qui se sont déjà demandé ce que font, disent et cliquent réellement les modérateurs lorsqu’ils prennent des décisions qui peuvent affecter des millions de personnes.

Ne faites pas attention à la conversation honnête et complexe derrière le rideau

Les chaînes d’e-mails, les conversations Slack et les captures d’écran (ou plutôt les captures d’écran) publiées au cours de la semaine dernière donnent un aperçu de ce processus important et mal compris. Ce que nous voyons est un peu de la matière première, qui n’est pas l’illuminati partisan auquel certains s’attendaient – même s’il est clair, par sa présentation très sélective, que c’est ce que nous sommes censés percevoir.

Loin de là : les acteurs sont tour à tour prudents et confiants, pragmatiques et philosophes, francs et accommodants, montrant que le choix de limiter ou d’interdire ne se fait pas arbitrairement mais selon un consensus évolutif de points de vue opposés.

(Mise à jour: Quelques instants après avoir posté ceci, un nouveau fil a commencé, c’est plus ou moins la même chose – des discussions sérieuses sur des questions complexes en coordination avec des experts, des forces de l’ordre et d’autres.)

Avant le choix de restreindre temporairement l’histoire de l’ordinateur portable Hunter Biden – probablement à ce stade la décision de modération la plus controversée de ces dernières années, derrière l’interdiction de Trump – il n’y a ni partisanerie ni complot insinué par l’emballage explosif des documents.

Au lieu de cela, nous trouvons des personnes sérieuses et réfléchies qui tentent de concilier des définitions et des politiques contradictoires et inadéquates : qu’est-ce qui constitue un contenu « piraté » ? Dans quelle mesure sommes-nous confiants dans telle ou telle évaluation ? Qu’est-ce qu’une réponse proportionnée ? Comment le communiquer, à qui et quand ? Quelles sont les conséquences si nous le faisons, si nous ne limitons pas ? Quels précédents établissons-nous ou brisons-nous?

Les réponses à ces questions ne sont pas du tout évidentes et sont le genre de choses généralement hachées au fil des mois de recherche et de discussion, ou même devant les tribunaux (les précédents juridiques affectent le langage juridique et les répercussions). Et ils devaient être faits rapidement, avant que la situation ne devienne incontrôlable d’une manière ou d’une autre. La dissidence de l’intérieur et de l’extérieur (d’un représentant américain, pas moins – ironiquement, doxxed dans le fil avec Jack Dorsey en violation de la même politique) a été prise en compte et honnêtement intégrée.

“Il s’agit d’une situation émergente où les faits restent flous”, a déclaré l’ancien chef de Trust and Safety, Yoel Roth. “Nous avons choisi d’inclure un avertissement et d’empêcher l’amplification de ce contenu.”

Certains remettent en cause la décision. Certains remettent en question les faits tels qu’ils ont été présentés. D’autres disent que ce n’est pas soutenu par leur lecture de la politique. L’un dit qu’ils doivent préciser très clairement la base ad hoc et l’étendue de l’action, car elle sera évidemment examinée comme une action partisane. L’avocat général adjoint Jim Baker demande plus d’informations, mais dit que la prudence est de mise. Il n’y a pas de précédent clair; les faits sont à ce stade absents ou non vérifiés ; une partie du matériel est une imagerie de nu manifestement non consensuelle.

“Je pense que Twitter lui-même devrait restreindre ce qu’il recommande ou met dans les nouvelles tendances, et votre politique contre les groupes QAnon est bonne”, concède le représentant Ro Khanna, tout en affirmant que l’action en question est un pas trop loin. “C’est un équilibre difficile.”

Ni le public ni la presse n’ont été au courant de ces conversations, et la vérité est que nous sommes aussi curieux et largement dans le noir que nos lecteurs. Il serait incorrect d’appeler les documents publiés une représentation complète ou même précise de l’ensemble du processus (ils sont manifestement, bien qu’inefficacement, sélectionnés et choisis pour s’adapter à un récit), mais même tels qu’ils sont, nous sommes plus informés que nous ne l’étions auparavant .

Outils du métier

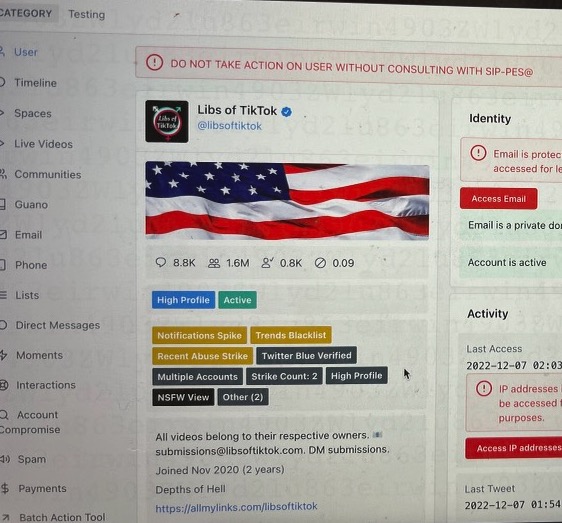

Encore plus directement révélateur était le fil suivant, qui contenait des captures d’écran de l’outil de modération réel utilisé par les employés de Twitter. Alors que le fil tente de manière malhonnête d’assimiler l’utilisation de ces outils à l’interdiction de l’ombre, les captures d’écran ne montrent pas d’activité néfaste, et elles n’en ont pas besoin pour être intéressantes.

Crédits image : Twitter

Au contraire, ce qui est montré est convaincant pour la simple raison qu’il est si prosaïque, si simplement systématique. Voici les différentes techniques que toutes les entreprises de médias sociaux ont expliquées à maintes reprises qu’elles utilisent, mais alors qu’auparavant, nous l’avions exprimée dans le ton diplomatique joyeux des relations publiques, elle est maintenant présentée sans commentaire : “Trends Blacklist”, “High Profile”, “DO NE PAS PRENDRE D’ACTION » et le reste.

Pendant ce temps, Yoel Roth explique que les actions et les politiques doivent être mieux alignées, que davantage de recherches sont nécessaires, que des plans sont en cours pour améliorer :

L’hypothèse sous-jacente à une grande partie de ce que nous avons mis en œuvre est que si l’exposition à, par exemple, la désinformation cause directement des dommages, nous devrions utiliser des mesures correctives qui réduisent l’exposition, et limiter la propagation/viralité du contenu est un bon moyen de le faire… nous sommes va devoir faire un dossier plus solide pour intégrer cela dans notre répertoire de mesures correctives politiques – en particulier pour d’autres domaines politiques.

Encore une fois, le contenu dément le contexte dans lequel il est présenté : ce ne sont pas les délibérations d’une cabale libérale secrète s’en prenant à ses ennemis idéologiques avec un marteau d’interdiction. Il s’agit d’un tableau de bord de niveau entreprise comme vous pouvez le voir pour le suivi des prospects, la logistique ou les comptes, discuté et itéré par des personnes sobres travaillant dans des limites pratiques et visant à satisfaire plusieurs parties prenantes.

Comme il se doit : Twitter, à l’instar de ses autres plates-formes de médias sociaux, travaille depuis des années pour rendre le processus de modération suffisamment efficace et systématique pour fonctionner à grande échelle. Non seulement pour que la plate-forme ne soit pas envahie par des robots et des spams, mais aussi pour se conformer aux cadres juridiques tels que les ordonnances de la FTC et le RGPD. (Dont les étrangers «à accès étendu et non filtré» ont été donnés à l’outil illustré pourraient bien constituer une violation. Les autorités compétentes ont déclaré à TechCrunch ils “s’engagent” avec Twitter à ce sujet.)

Une poignée d’employés prenant des décisions arbitraires sans rubrique ni surveillance n’est pas un moyen de modérer efficacement ou de répondre à de telles exigences légales ; ni (comme le démission de plusieurs sur Twitter Trust & Safety Council témoigne aujourd’hui) est l’automatisation. Vous avez besoin d’un vaste réseau de personnes coopérant et travaillant selon un système standardisé, avec des limites claires et des procédures d’escalade. Et c’est certainement ce que semblent montrer les captures d’écran que Musk a fait publier.

Ce qui n’est pas montré par les documents, c’est une sorte de parti pris systématique, que les remplaçants de Musk insinuent mais ne parviennent pas tout à fait à prouver. Mais que cela corresponde ou non au récit qu’ils souhaitent, ce qui est publié intéresse tous ceux qui pensent que ces entreprises devraient être plus ouvertes sur leurs politiques. C’est une victoire pour la transparence, même si l’approche opaque de Musk l’accomplit plus ou moins par accident.